配置spark服务

安装

执行tar -zxvf spark-2.0.2-bin-hadoop2.6.tgz解压spark服务文件即可。

配置

配置 /spark-2.0.2-bin-hadoop2.6/conf/spark-env.sh文件,添加如下内容

export JAVA_HOME=/opt/jdk1.8.0_131 # 注意为实际JDK安装路径

export SPARK_MASTER_HOST=spark1

export SPARK_MASTER_PORT=7077

export SPARK_WORKER_OPTS="-Dspark.worker.cleanup.enabled=true -Dspark.worker.cleanup.interval=1800 -Dspark.worker.cleanup.appDataTtl=604800"

- 下载解压后,如您未发现spark-env.sh文件,将带有template结尾的spark-env.sh另存一份即可

- 修改/etc/hosts文件,添加如下内容,重启操作系统生效

实际Ip地址 spark1- 如果Linux操作系统SSH端口不是默认22,需修改

/spark-2.0.2-bin-hadoop2.6/conf/spark-env.sh文件增加export SPARK_SSH_OPTS="-p 1234",1234需替换为实际的端口号。

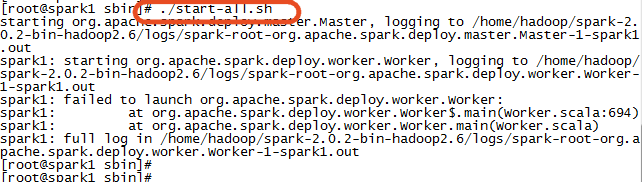

启动

执行./spark-2.0.2-bin-hadoop2.6/sbin/start-all.sh脚本启动

开机自启动设置

进入到

/etc/init.d目录下,编辑一个新的脚本文件sparkcd /etc/init.d touch spark vi spark- 编辑脚本文件

spark#!/bin/bash #chkconfig:2345 20 90 #description:spark #processname:spark export JAVA_HOME=/opt/jdk1.8.0_131 <!--注意需替换为实际路径 --> case $1 in start) su root /opt/spark-2.0.2-bin-hadoop2.6/sbin/start-all.sh;;<!--注意需替换为实际路径 --> stop) su root /opt/spark-2.0.2-bin-hadoop2.6/sbin/stop-all.sh;; <!--注意需替换为实际路径 --> *) echo "require start|stop" ;; esac - 保存退出,用chmod修改该文件权限

chmod +x spark - 设置

spark为开机自启动chkconfig --add spark - 然后就能查看到设置好的

spark服务了chkconfig --list spark

验证启动是否成功

在终端执行 jps 命令,输出如下信息表示启动成功

29711 Master

14737 Worker

停止

执行./sparkspark-2.0.2-bin-hadoop2.6/sbin/stop-all.sh脚本停止

- 若

spark为集群部署,则在/sparkspark-2.0.2-bin-hadoop2.6/conf/slaves文件中增加两个节点服务器名即可- 有关Spark的更多信息请参见http://spark.apache.org/

Seven

010-62962343-690

liujx@actionsoft.com.cn

感谢您对该文档的关注!如果您对当前页面内容有疑问或好的建议,请与我联系。如果您需要解答相关技术问题请登录AWS客户成功社区