ClickHouse安装

ClickHouse 是一款高性能的列式数据库,特别适用于大数据的实时分析。以下是 ClickHouse 的安装与配置步骤。

1. 安装

首先,确保 ClickHouse 的 rpm 安装包已经上传到 /opt 目录:

clickhouse-client-21.9.7.2-2.noarch.rpm

clickhouse-common-static-21.9.7.2-2.x86_64.rpm

clickhouse-common-static-dbg-21.9.7.2-2.x86_64.rpm

clickhouse-server-21.9.7.2-2.noarch.rpm

现在,使用 rpm 包进行安装。在安装过程中,可能会有提示要求您输入密码,该密码在后续配置中会被使用,请确保记住。

rpm -ivh *.rpm

2. 核实安装

通过以下命令查看 ClickHouse 是否已成功安装:

rpm -qa|grep clickhouse

3. 配置远程访问

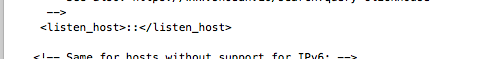

为了允许远程访问,您需要修改配置文件。确保解除 <listen_host>::</listen_host> 的注释。

vim /etc/clickhouse-server/config.xml

解释:

在ClickHouse的/etc/clickhouse-server/config.xml配置文件中,<listen_host>::</listen_host>设置指定ClickHouse服务器应该在哪个IP地址上监听客户端连接。

具体地说,<listen_host>::</listen_host>配置使ClickHouse在所有IPv6地址上监听,这意味着它将接受从任何IPv6地址发来的连接请求。如果您的系统支持IPv6到IPv4的映射,它还可以接受来自任何IPv4地址的连接。

如果在ClickHouse的/etc/clickhouse-server/config.xml配置文件中,<listen_host>标签设置为特定的IP地址,ClickHouse服务器将仅在该指定的IP地址上监听客户端连接。

例如:

- 如果设置为

<listen_host>192.168.1.10</listen_host>,ClickHouse仅在IP地址192.168.1.10上监听客户端连接请求。 - 如果设置为

<listen_host>2001:0db8:85a3:0000:0000:8a2e:0370:7334</listen_host>,ClickHouse仅在该IPv6地址上监听客户端连接请求。

这样,只有通过这些指定的IP地址的请求才能到达ClickHouse,其他所有IP地址的请求都将被拒绝。这可以增加安全性,限制只有某些网络或主机能够访问ClickHouse实例。

注意事项

- 如果你的集群是单机版,并且已经有服务在 9000 端口上运行,例如 Hadoop,你需要更改 ClickHouse 的端口。建议更换到一个不常用的端口,如 49160。

- 在使用客户端连接 ClickHouse 时,确保指定新的端口,例如:

clickhouse-client -m --port 49160 --password yourPassword。 - 客户端连接的默认端口无法通过配置文件进行更改,您必须在每次连接时手动指定。

4. 启动服务

启动 ClickHouse Server:

systemctl start clickhouse-server

解释:

使用systemctl start clickhouse-server命令将启动ClickHouse服务。这使得ClickHouse数据库服务在系统级别开始运行,接受客户端的连接和查询请求。

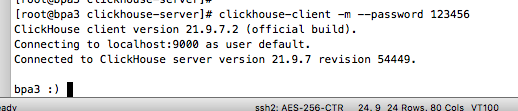

使用客户端连接:

clickhouse-client -m --password <密码>

解释:

该命令启动ClickHouse的客户端并尝试连接到ClickHouse服务器。其中:

-m:以多行模式运行,使得SQL查询可以跨多行输入。--password <密码>:为连接到ClickHouse服务器提供密码。

简而言之,该命令用于以多行模式启动ClickHouse客户端并使用指定密码进行身份验证。

5. JAR包适配

为了确保 Spark 可以与 ClickHouse 进行交互,您需要添加必要的 JAR 文件到 Spark 的 JARS 目录。

- 将 ClickHouse 驱动包放入 Spark 安装目录下的 jars 文件夹:

cp clickhouse-jdbc-0.3.1.jar /opt/spark-2.3.2-bin-hadoop2.6/jars/

- 同样,将 guava JAR 放入 Spark 的 jars 目录:

cp guava-16.0.1.jar /opt/spark-2.3.2-bin-hadoop2.6/jars/注意:请确保在整个集群的每个节点上都进行 JAR 包适配操作。可使用scp命令快速将上述jar复制到其他集群节点

scp -r /opt/clickhouse-jdbc-0.3.1.jar 用户名@主机:/opt/spark-2.3.2-bin-hadoop2.6/jars/、scp -r /opt/guava-16.0.1.jar.jar 用户名@主机:/opt/spark-2.3.2-bin-hadoop2.6/jars/

:bulb:常见问题